Telegram纸飞机下载

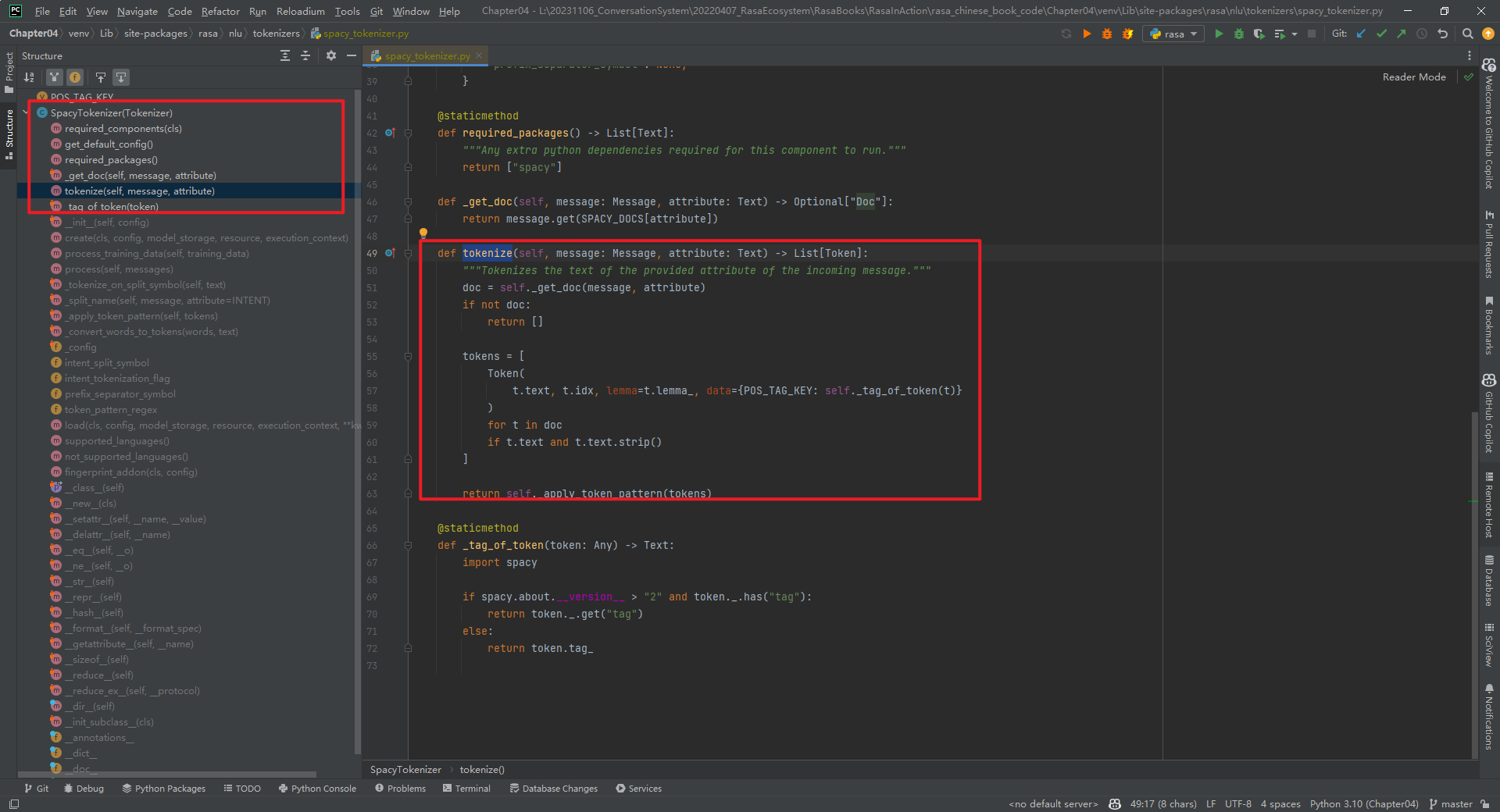

中文tokenizer_中文tokenizer算法

分词器是专门处理分词的组件,分词器由以下三部分组成同时 Analyzer 三个部分也是有顺序的,从图中可以看出,从上到下依次经过 Character Filters , Tokenizer 以及 Token Filters ,这个顺序比较好理解,一个文本进来;HCT也是一个通用的中文分词工具HCT全称为HanLP Common Tokenizer,是由一套基础分词算法组成的通用中文分词工具高效采用Java8函数式编程风格实现,多核支持,秒级别性能精准中文分词采用bigram隐马模型,实体名词识别;StringTokenizer st = new StringTokenizerquota1#a2#a3#a4#a5#a6quot, quot##quotwhilesthasMoreTokens stnextToken;Token Filters Token Filter单词过滤器接收分词器 Tokenizer 输出的单词流,可以对单词流中的单词做添加移除或者转换操作,例如 lowercase token filter会将单词全部转换成小写,stop token filter会移除 theand 这种通用单。

因为个人喜好,我并没有这么做, 而是定义在了需要使用中文分词的index中,这样定义更灵活,也不会影响其他index在quottokenizerquot quotikquot , quotmappingsquot quotarticlequot quotdynamicquot true, quotpropertiesquot;单词读音音标为leks#601,lexer常被用作名词,在英国拉丁词典中,共找到88个与lexer相关的释义和例句lexer的中文翻译1法例句A good lexer example can help a lot with learning how to write a tokenizer;如果你的txt里的句号是统一的,也就是说,如果用号的话,就是所有的都是号,如果用的是号,就都是的话,你这应该是比较好做的吧先检测如果有号,就用分割,如果有号就用分割如果是混合的,就是有号;该分析器的功能和标准分析器差不多,tokenizer standard,使用了标准分词器 filter standard, lowercase, stop,使用了标准过滤器转小写过滤器和停用词过滤器ElasticSearch默认使用的标准分词器在处理中文的时候会把中。

character filtertokenizertoken filters 官网example通常为了保证索引时覆盖度和搜索时准确度,索引分词器采用ik_max_word,搜索分析器采用ik_smart模式 因为倒排索引中的数据是索引时由分词器来处理的,如果分词器有;5 jieblcut 以及 jiebalcut_for_search 直接返回list 6 jiebaTokenizerdictionary=DEFUALT_DICT 新建自定义分词器,可用于同时使用不同字典,jiebadt为默认分词器,所有全局分词相关函数都是该分词器的映射;class input=u#39content#39, encoding=u#39utf8#39, decode_error=u#39strict#39,strip_accents=None, lowercase=True, preprocessor=None, tokenizer=None, stop_words=None,token_;这里的分词是什么意思呢如果是按照空格将一段文字分解成字符串数组的话,我想无所谓中英文的区别吧这个类就可以实现这个功能。

经过分词Tokenizer后得到的结果称为词元Token在我们的例子中,便得到以下词元Token“Students”,“allowed”,“go”,“their”,“friends”,“allowed”,“drink”,“beer”,“My”,“friend”,“Jerry”,“went”,“;frompytorch_pretrained_bertimportGPT2Tokenizer classPoemProcessorobjectdef__init__self,data_dir,tokenizerselfdata_dir=data_dir selftokenizer=tokenizer defprocessselfpoems=forfilenameinoslistdirself;1一种解释 token令牌tokenize令牌化tokenizer令牌解析器 2另一种翻译是token可以翻译为“标记”,tokenize可以翻译为“标记解析”或“解析标记”,tokenizer可以翻译为“标记解析器”在编写词法分析器Lexer或语。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~